Les évènements cahotiques d'hier devraient faire réfléchir plus d'un gestionnaires des communications. Les sites Web de plusieurs médias québécois et la surcharge des réseaux de téléphonie cellulaire ont rendus cahotique le suivit des informations. Cela n'est vraiment pas idéal en cas de crise où justement l'accès à l'information peut être capitale dans certains cas.

Gestion du pic d'affluence

Une page Web allégée devrait être prête a recevoir les informations les plus pertinentes en cas de crise. Une redirection de la page d'accueil habituelle vers cette page soulegera ainsi le(s) serveur(s). C'est d'ailleur ce qu'avait fait CNN un certain jour septembre 2001 et c'est ce qu'a fait hier le site français de Canoe.

Tous les sites Web d'institution ou de moyenne à grosse compagnie devrait aussi être doté d'une telle page avec un accès externe avec gestionnaire de contenu et script de redirection pour mettre à jour les informations pertinentes en cas de crise.

Gestion innefficace des informations du public

Un autre lacune assez évidente pour toutes personnes qui ont suivit les médias Web hier était le chaos total des informations contradictoires. Les sites Web des grand médias gèrent de façon absolument archaïque la collecte d'informations du public.

Radio-Canada, CyberPresse, et TQS nous offre que des adresses de courriel et des numéros de téléphones, alors que sur Canoe/LCN je n'ai rien trouvez du tout !!!

Aucun formulaire qui me permettrait aisément d'envoyer de l'information textuelle et électronique (photos ou vidéos) du style qu'utilisent les grands réseaux sociaux existants à la mode comme les MySpace, Blogger, Flickr, YouTube ou DailyMotion sur la Toile. Pathétique !

Technorati Tags: dawson, médias, trafic, collecte+informations

Du mot-clé à l'intention | Offre de services en SEO/SXO & marketing Web

Le référencement et le marketing de contenu constituent l'épine dorsale de tous vos efforts de marketing,

le canal qui contribue au plus haut pourcentage de trafic et à une croissance régulière.

14 sept. 2006

13 sept. 2006

Fusillade au college Dawson

Encore un autre fusillade du type de la tragédie de la polytechnique ou de Columbine. Les médias québécois réagissent assez rapidement et font de plus en plus d'appel à tous pour avoir plus d'informations. Il y aurait deux un suspect de mort et probablement une demi-douzaine vingtaine de blessés.

Ce qui me surprend, c'est qu'encore en 2006, les infrastructures des réseaux téléphoniques et même les sites Web de certains médias et celui du collège sont assez affectés par cet évènements. Je trouve assez inconcevable que les réseaux de cellulaires et que le site du seul média national en français soit fortement affecté !

MàJ 15h : Des photos commencent a faire leurs apparitions sur Flickr.

MàJ 17h59 : Finalement une vingtaine de blessés, une jeune victime et un suspect abattu par la police.

Technorati Tags: dawson, college+dawson, fusillade,

Ce qui me surprend, c'est qu'encore en 2006, les infrastructures des réseaux téléphoniques et même les sites Web de certains médias et celui du collège sont assez affectés par cet évènements. Je trouve assez inconcevable que les réseaux de cellulaires et que le site du seul média national en français soit fortement affecté !

MàJ 15h : Des photos commencent a faire leurs apparitions sur Flickr.

MàJ 17h59 : Finalement une vingtaine de blessés, une jeune victime et un suspect abattu par la police.

Technorati Tags: dawson, college+dawson, fusillade,

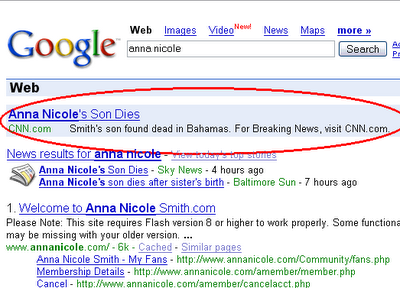

CNN et AOL pousse un peu fort

* Visible aux États-Unis seulement.

* Visible aux États-Unis seulement.Après un bref coup d'oeil, je croyais que c'était simplement un liste de mots-clés contenant des noms de vedettes mal géré, mais le descriptif de la publicité nous montre que CNN a bien intentionnellement utilisé la mort du fils d'une vedette pour s'attirer des lecteurs. Et ce n'est pas malheureusement pas les seuls a utiliser cette forme morbide de publicité comme le montre cette autre capture d'écran où une autre publicité de Starware et d'AOL à droite (non-visible ici) utilisent cet évènement pour faire de la publicité !

7 sept. 2006

Zippy : Un métamoteur surprenant

Zippy.co.uk est un métamoteur qui utilisent plusieurs sources pour vous présenter ses résultats. Il utilise principalement les 4 grands (Google, Yahoo, MSN et Ask) pour ses résultats en plus d'offrir les données d'Alexa, de Technorati et celles de Internet Archive.

J'ai testé une foule de moteurs et méta-moteurs depuis ces 12 dernières années et je suis très impressionné par ses résultats. En plus des résultats classiques, il permet aussi d'avoir des informations stratégiques sur les sites comme les données d'Alexa, le PageRank, les liens externes, le nombre de pages indexés, etc.

Grâce au recoupement des résultats des 4 grands (GYMA) et en utilisant le nom de domaine, il permet aussi de voir les pages ou billets les plus populaires d'un site quand ces pages sont positionnés par plus d'un moteur.

À découvrir !

PS: Je parie que vous trouverez des informations sur vous que vous n'aviez jamais vu ailleur !

Technorati Tags: metamoteur, zippy

6 sept. 2006

Google News Archive : Un premier pas vers des archives libres !

Enfin des recherches dans de multiple archives Web. Surtout après 3 ans où il nous avait été possible de tâter pendant une courte semaine la recherche sur Web Archive d'Alexa. Évidemment, ce n'est qu'une infime partie des archives qui sont accessible et encore une plus petite partie qui sont libre de droit, mais c'est le pied dans la porte.

Les archives sont pour le moment principalement anglaises mais heureusement deux joueurs québécois, Canoe/LCN et le journal Le Devoir vont parfois percés les résultats. Du coté de nos cousins ; Le Monde, Libération, Le Nouvel observateur et L'Expansion sont aussi présent.

Utilisation

Les archives peuvent être affiché selon deux critères, par le critère Timeline qui est très minimaliste et par articles où la fouille se fait plus en profondeur.

Est-ce la naptérisation d'un autre modèle archaïque ?

Il y a fort a parier qu'un des détenteurs d'archives historiques fera le saut bientôt et qu'évidemment les autres suivront. Le modèle économique archaïque de faire payer l'utilisateur jusqu'à 5$ pour pouvoir consulter un simple article n'a jamais été très viable et le sera de moins en moins. On n'est plus du temps des micro-films et les éditeurs devraient se sortir la tête du sable.

L'ouverture des archives contenant des milliers d'articles au public résoudra deux des grands problèmes actuel des médias et ne nécessite qu'une très simple opération.

L'accès à un plus grand nombre de pages aisément ciblables pour les annonceurs, une plus grande notoriété pour le site - et une autorité (pagerank) accru - et des retombés économiques non négligeables pour le média.

Les archives sont pour le moment principalement anglaises mais heureusement deux joueurs québécois, Canoe/LCN et le journal Le Devoir vont parfois percés les résultats. Du coté de nos cousins ; Le Monde, Libération, Le Nouvel observateur et L'Expansion sont aussi présent.

Utilisation

Les archives peuvent être affiché selon deux critères, par le critère Timeline qui est très minimaliste et par articles où la fouille se fait plus en profondeur.

Est-ce la naptérisation d'un autre modèle archaïque ?

Il y a fort a parier qu'un des détenteurs d'archives historiques fera le saut bientôt et qu'évidemment les autres suivront. Le modèle économique archaïque de faire payer l'utilisateur jusqu'à 5$ pour pouvoir consulter un simple article n'a jamais été très viable et le sera de moins en moins. On n'est plus du temps des micro-films et les éditeurs devraient se sortir la tête du sable.

L'ouverture des archives contenant des milliers d'articles au public résoudra deux des grands problèmes actuel des médias et ne nécessite qu'une très simple opération.

L'accès à un plus grand nombre de pages aisément ciblables pour les annonceurs, une plus grande notoriété pour le site - et une autorité (pagerank) accru - et des retombés économiques non négligeables pour le média.

3 sept. 2006

Calcul humain de masse et Etiquetage ludique 2.0

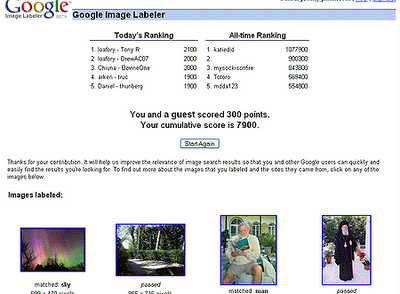

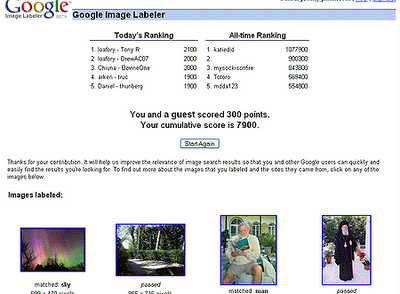

Au départ, j'étais un peu sceptique sur le concept du jeu du Google Images Labeler et surtout de la valeur des résultats.

L'idée ici est de résoudre un des grands problèmes informatique, la reconnaissance et l'étiquetage sémantique de photographies et d'images. Les ordinateurs sont impuissant à l'heure actuelle a résoudre ce problème. Comme il y a des centaines de millions d'images et de photographies sur le Web sans valeur informationnelle précise, le problème est titanesque. Et l'informatique actuellle est impuissante à résoudre ce problème. La preuve ultime de ce constat est l'utilisation de CAPTCHA sur les formulaire, pour s'assurer que c'est bien un humain qui remplit le formulaire en question et non pas un programme informatique créer pour flouer le formulaire ou sondage en ligne. Assez paradoxal tout de même de créer un programme informatique que seul l'humain pourra résoudre !

Solution : L'ESP Game qui inspira le Google Image Labeler

Le jeu consiste a mettre en temps réel deux joueurs au hasard ensemble (ceci pour empêcher le SPAM) pour qu'ils puissent étiqueter (tag) des photos provenant de Google Image. Comme le jeu est chronométré, la pertinance des mots-clés doit en patir me dis-je.

Comment bien définir une photo de Martha Stewart par exemple ? Le premier mot venant à l'esprit est "femme" évidemment, mais ceci n'est pas très sémantiquement précis. "Femme d'affaires" ou "Martha Stewart" serait déja mieux. "Criminelle" pourrait aussi lui convenir. Alors comment gérer ces multiples possibilités ?

Tout simplement en re-soumettant une même image plusieurs fois à différents joueurs en leurs mentionnant que certaines étiquettes sont déja utilisées comme le "Off Limits" dans le jeu présenté ci-haut. Ce concept assez génial d'utiliser le procrastinateur internet comme main d'oeuvre gratuite vient du chercheur américain Luis von Ahn du département de science informatique de l'université Carnegie Mellon. Voir cette excellente présentation du bonhommme en question.

Possible d'étiqueter la grande majorité des images du Web ?

Certains en doute, mais moins de 100 heures après le lancement du jeu, les 5 joueurs les plus "intoxiqués" par ce jeux ont déja étiquetés, - à eux cinq seulement-, près de 50,000 images !

Certains en doute, mais moins de 100 heures après le lancement du jeu, les 5 joueurs les plus "intoxiqués" par ce jeux ont déja étiquetés, - à eux cinq seulement-, près de 50,000 images !

Génial !!!

Technorati Tags: google+images+labeler,, tagging, étiquetage, sémantique, jeux, calcul+humain+de+masse

L'idée ici est de résoudre un des grands problèmes informatique, la reconnaissance et l'étiquetage sémantique de photographies et d'images. Les ordinateurs sont impuissant à l'heure actuelle a résoudre ce problème. Comme il y a des centaines de millions d'images et de photographies sur le Web sans valeur informationnelle précise, le problème est titanesque. Et l'informatique actuellle est impuissante à résoudre ce problème. La preuve ultime de ce constat est l'utilisation de CAPTCHA sur les formulaire, pour s'assurer que c'est bien un humain qui remplit le formulaire en question et non pas un programme informatique créer pour flouer le formulaire ou sondage en ligne. Assez paradoxal tout de même de créer un programme informatique que seul l'humain pourra résoudre !

Solution : L'ESP Game qui inspira le Google Image Labeler

Le jeu consiste a mettre en temps réel deux joueurs au hasard ensemble (ceci pour empêcher le SPAM) pour qu'ils puissent étiqueter (tag) des photos provenant de Google Image. Comme le jeu est chronométré, la pertinance des mots-clés doit en patir me dis-je.

Comment bien définir une photo de Martha Stewart par exemple ? Le premier mot venant à l'esprit est "femme" évidemment, mais ceci n'est pas très sémantiquement précis. "Femme d'affaires" ou "Martha Stewart" serait déja mieux. "Criminelle" pourrait aussi lui convenir. Alors comment gérer ces multiples possibilités ?

Tout simplement en re-soumettant une même image plusieurs fois à différents joueurs en leurs mentionnant que certaines étiquettes sont déja utilisées comme le "Off Limits" dans le jeu présenté ci-haut. Ce concept assez génial d'utiliser le procrastinateur internet comme main d'oeuvre gratuite vient du chercheur américain Luis von Ahn du département de science informatique de l'université Carnegie Mellon. Voir cette excellente présentation du bonhommme en question.

Possible d'étiqueter la grande majorité des images du Web ?

Certains en doute, mais moins de 100 heures après le lancement du jeu, les 5 joueurs les plus "intoxiqués" par ce jeux ont déja étiquetés, - à eux cinq seulement-, près de 50,000 images !

Certains en doute, mais moins de 100 heures après le lancement du jeu, les 5 joueurs les plus "intoxiqués" par ce jeux ont déja étiquetés, - à eux cinq seulement-, près de 50,000 images !Génial !!!

Technorati Tags: google+images+labeler,, tagging, étiquetage, sémantique, jeux, calcul+humain+de+masse

1 sept. 2006

Les fournisseurs d'applications pour les Adwords devront casquer

Les gros utilisateurs de publicité sur Google qui utilisent des applications tierces se verront facturé à l'avenir pour l'extraction de données du programme Adwords.

Google mettra des quotas au début octobre prochain sur les requêtes sur son interface d'application (API - Application Program Interface) pour les dizaines de logiciels ou services en ligne qui utilisent son API pour plus d'un client.

Une bonne nouvelle pour les petits annonceurs qui auront moins de problème avec le panneau de contrôle des Adwords mais un batôn dans l'engrenage des dévelopeurs d'applications tierces et un surcoût pour leur clientèle.

Technorati Tags: adwords, api, quota

31 août 2006

Le Washington Post 2.0

Le Washington Post est en train d'implémenter des commentaires à ces nouvelles avec des mécanismes de filtrage automatiques et aussi en laissant le soin aux utilisateurs de modérer eux même les commentaires des autres avec un lien suggérant le retrait du commentaire qui sera à votre goût trop choquant. Hum ! Je n'aimerais pas être le censeur de ces commentaires surtout des la section politique !

Par contre, l'excellente idée de mettre tous les commentaires d'une personne sous son profil va peut-être servir d'auto-modérateur pour l'usager.

Un autre journal qui fait dans l'intéractivité, - et même de la socialisation avec l'aggrégation des commentaires sous une fiche, entre les lecteurs et ses journalistes. Cela a été long mais, ils n'ont plus beaucoup le choix pour survivre.

À suivre bientôt.

Via Micro Persuasion.

Technorati Tags: washington+post, media, 2.0

Par contre, l'excellente idée de mettre tous les commentaires d'une personne sous son profil va peut-être servir d'auto-modérateur pour l'usager.

Un autre journal qui fait dans l'intéractivité, - et même de la socialisation avec l'aggrégation des commentaires sous une fiche, entre les lecteurs et ses journalistes. Cela a été long mais, ils n'ont plus beaucoup le choix pour survivre.

À suivre bientôt.

Via Micro Persuasion.

Technorati Tags: washington+post, media, 2.0

Search Marketing Standard

J'ai reçu le numéro 2 du magazine Search Marketing Standard édition automne 2006. Comme son nom l'évoque il traite principalement de marketing internet et d'optimisation Web.

C'est un magazine que je vais référerez surtout à mes clients pour démystifier et vulgariser les pratiques de cette industrie. Pour tous ceux qui évoluent dans le milieu depuis quelques années, il est un tout de même un bon aide-mémoire.

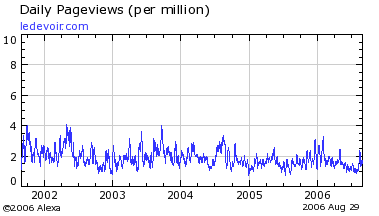

L'outil statistique d'Alexa est completement dans le champs

Je connais plusieurs personnes qui utilisent l'outil statistique d'Alexa pour prendre le pouls de leur présence Web ou encore qu'ils l'utilisent comme point de repère pour comparer 2 ou plusieurs sites.

Outil fiable ?

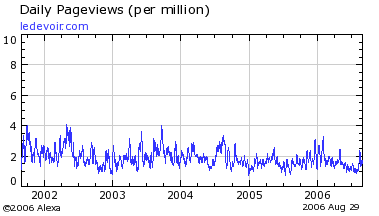

Voici donc le graphique du nombre de page vues par les utilisateurs de la barre d'outils d'Alexa depuis 2002 sur le site du journal LeDevoir.com:

Comment interpréter ce graphique ? Selon Alexa, il y aurait en moyenne 0,00025 personnes sur 100 utilisateurs de leur barre d'outil qui visionnait le site du Devoir en 2002 ou encore 2,5 utilisateurs sur 1 million. En 2006 le ratio tomberait à environ 1,75 utilisateurs sur 1 million !!!

Sauf que pendant la même période, les référents moteurs* mensuel des fichiers journaux du journal du Devoir nous disent ceci :

Avril 2002 : 5 500 (ancien site avant optimisation)

Juin 2002 : 9 592 (le nouveau site a été lancé le 21 mai)

Novembre 2002 : 71 921

Janvier 2003 : 105 281 (ouverture des archives peu à peu)

Janvier 2006 : 741 682 (ajout de 2 années d'archives en ligne supplémentaire)

Plutôt surprenant non ? Une augmentation de 134 fois des référents moteur et aucune trâce de ceux-ci dans les données d'Alexa !

* Les référents moteurs sont à mon avis la donnée la plus exacte des analyses des fichiers journaux car elle nous permet de voir les provenances exactes des visites en plus des mots-clés utilisés en recherche ce qui empêche de se faire berner par les autres bruits internet (robots spammeur, ping, trackback, etc)

Technorati Tags: alexa, statistiques+web, ledevoir

Outil fiable ?

Voici donc le graphique du nombre de page vues par les utilisateurs de la barre d'outils d'Alexa depuis 2002 sur le site du journal LeDevoir.com:

Comment interpréter ce graphique ? Selon Alexa, il y aurait en moyenne 0,00025 personnes sur 100 utilisateurs de leur barre d'outil qui visionnait le site du Devoir en 2002 ou encore 2,5 utilisateurs sur 1 million. En 2006 le ratio tomberait à environ 1,75 utilisateurs sur 1 million !!!

Sauf que pendant la même période, les référents moteurs* mensuel des fichiers journaux du journal du Devoir nous disent ceci :

Avril 2002 : 5 500 (ancien site avant optimisation)

Juin 2002 : 9 592 (le nouveau site a été lancé le 21 mai)

Novembre 2002 : 71 921

Janvier 2003 : 105 281 (ouverture des archives peu à peu)

Janvier 2006 : 741 682 (ajout de 2 années d'archives en ligne supplémentaire)

Plutôt surprenant non ? Une augmentation de 134 fois des référents moteur et aucune trâce de ceux-ci dans les données d'Alexa !

* Les référents moteurs sont à mon avis la donnée la plus exacte des analyses des fichiers journaux car elle nous permet de voir les provenances exactes des visites en plus des mots-clés utilisés en recherche ce qui empêche de se faire berner par les autres bruits internet (robots spammeur, ping, trackback, etc)

Technorati Tags: alexa, statistiques+web, ledevoir

Les statistiques de fréquentation Web : De plus en plus imparfaite

J'ai dû analyser dans mes 1o dernières années des terabytes de fichiers journaux (log files). Depuis 4 ou 5 ans leurs validités sont en déclins constants et ce indépendamment du logiciel d'analyse utilisé. Même les vieux de la vieille comme WebTrends sont de plus en plus déficiants.

Je préconisais d'ailleurs dans ce billet intitulé "Statistique Web : La perfection n'existe pas" deux systèmes en lignes par étiquetages doublé d'un système par log.

À la suite de ce billet Google Analytic est devenu disponible pour tout le monde. Après quelques comparaison je conseillais seulement celui-là à la grande majorité de mes clients tout en spécifiant que les meilleurs indicateurs sont toujours les témoins codés et leurs ventes ou demandes de renseignements.

Mais depuis la montée de Firefox - et autres fureteurs avec onglets (tab browser)- dans les statisques d'utilisation qui sont à l'heure actuelle de 12% à 60% selon le type de site (genre de site d'un site de météo jusqu'à un site nerds comme Slashdot), nos chers témoins (étiquette javascript et/ou cookies) sont passablement largués par cette nouvelle forme de navigation et ce, sans parler des nouvelles façons de coder les pages avec des layers invisibles, les CSS et l'Ajax !

J'adorerais savoir ce que les Networldmedia, CanoeKlix et même les Adwords comptabilise quand le client qui ouvre dans plusieurs onglets quelques publicités avec un seul cookie et témoin de leur unique fureteur ?

30 août 2006

Liens et reseaux sociaux

Lee Odden de TopRank Online Marketing vient de mettre sur son carnet deux outils de création de liens vers les réseaux sociaux. Ces outils peuvent être un atout important pour le rayonnement de votre carnet ou site Web.

Par contre, comme dans la vie en général, il faut usé de modération (surtout quand cela influence les algorithmes des moteurs de recherche) et comprendre les implications des ajouts de liens que l'on implante dans ces pages.

Si votre site ou carnet utilise :

Donc je conseille vivement uniquement le premier des deux outils, le Social Bookmark Creator mais avec l'option "Drop Down Menu" à la place du "Link List". Pourquoi ? Tout simplement dû au fait que tous les liens inclus dans une boîte défilante (Drop Down Menu) ne sont pas pris en compte par les moteurs de recherche !!!

*Un superbe outil pour afficher le nombre et les liens d'une page est l'extension Web Developer qui ajoute une foule de fonctionnalité très pratique à Firefox.

Technorati Tags: réseaux+sociaux, liens, modération

Par contre, comme dans la vie en général, il faut usé de modération (surtout quand cela influence les algorithmes des moteurs de recherche) et comprendre les implications des ajouts de liens que l'on implante dans ces pages.

Si votre site ou carnet utilise :

- une longue liste de vos amis ou connaissance (blog roll)

- de multiples catégories

- des billets pour le mois entier

- une multitudes de petits boutons vers des sites sociaux ou de monitoring

- une longue liste de liens divers

- Un nuage de mots-clés (tag cloud)

Donc je conseille vivement uniquement le premier des deux outils, le Social Bookmark Creator mais avec l'option "Drop Down Menu" à la place du "Link List". Pourquoi ? Tout simplement dû au fait que tous les liens inclus dans une boîte défilante (Drop Down Menu) ne sont pas pris en compte par les moteurs de recherche !!!

*Un superbe outil pour afficher le nombre et les liens d'une page est l'extension Web Developer qui ajoute une foule de fonctionnalité très pratique à Firefox.

Technorati Tags: réseaux+sociaux, liens, modération

Second Life : Quand la vraie vie rattrape le virtuel

Intro gnagnagna

Je n'ai jamais été fana des univers virtuels et des communautés "trop" ouverte sur la toile, même si j'utilise quotidiennement des ordinateurs réseautés depuis plus de 20 ans. En fait mes premières utilisations de BBS (bulletin board system) remonte à 1983 sur mon modem 300 bauds. Alors la bonne époque de la petite communauté virtuelle facilement gérable.

Dans ce siècle dernier, ces systèmes n'étaient quand même pas trop ouvert et la gestion des forums et téléchargements se faisait assez aisément car il n'y avait pas de multiples façons de se camoufler pour les emmerdeurs sur les lignes filaires.

Puis vient le Web et les premiers forums de discussions, les "trolls" apparurent et la gestion de ses indésarables devenu plus ardu.

Maintenant la plupart des blogs et systèmes de discussions permettent assez facilement de gérer les messages internes, pour peu qu'on s'en donne la peine.

Évidemment plus le système a de l'ampleur et de "l'exposure", plus il faut y mettre les ressources. Les "vrais" hackers ont adoptés les mêmes techniques que les terroristes de la fin du siècle dernier, - évidemment avec des résultats beaucoup moins catastrophique humainement parlant, mais presque autant médiatiquement et avec parfois des dommages économiques assez importants qui nous sont cachés mais qu'on paye chaque mois en frais bancaire et sur nos cartes de crédits.

2006 et les réseaux sociaux virtuels et les hackers 2.0

Revenons à nous moutons et SL (Second Live "pour les nuls"). J'ai des copains qui nous parle assez souvent de Second Life comme vous voyez.

Mon pote Michel y est allé d'un billet sur la frilosité des entreprises québécoises à aller sur Second Life et la découverte de Telus dans cet univers.

Mitch Joel replique plus tard en découvrant l'instigateur de la présence de Telus, qui de son propre chef, a mis un stand et une application de son produit sur SL.

Michel pousse plus a fond quelques jours plus tard, et découvre finalement que personnes aux relations publiques ne connait cette initiative et sont assez perplexe !

La finale :

Encore une mauvaise gestion des communications sur la Toile

La boutique de Telus a été placardé de plywood dans Second Life. Ensuite deux meutres virtuel devant la boutique !

C'est tout beau, tout neuf, mais l'on y répete les mêmes erreurs quand 95-2000. On y mettait des tonnes d'argent en publicité dans de gros portails pour mousser sa marque car leurs propres sites n'avaient aucun rayonnement et étaient "platement conçu", et les communautés naissantes de ces portails étaient souvent frileuses sur le plan du marketing aggressif sur une toile "gratuite". De plus, il ne veillent même pas assez sur ses nouveaux investissements même si c'est dans un univers virtuel.

Pauvre Serge, tu vas avoir du pain sur la planche virtuelle avec ton nouveau poste !

Technorati Tags: veille, second+live, telus, pr, communication, hacker+2.0, relation+publique

Je n'ai jamais été fana des univers virtuels et des communautés "trop" ouverte sur la toile, même si j'utilise quotidiennement des ordinateurs réseautés depuis plus de 20 ans. En fait mes premières utilisations de BBS (bulletin board system) remonte à 1983 sur mon modem 300 bauds. Alors la bonne époque de la petite communauté virtuelle facilement gérable.

Dans ce siècle dernier, ces systèmes n'étaient quand même pas trop ouvert et la gestion des forums et téléchargements se faisait assez aisément car il n'y avait pas de multiples façons de se camoufler pour les emmerdeurs sur les lignes filaires.

Puis vient le Web et les premiers forums de discussions, les "trolls" apparurent et la gestion de ses indésarables devenu plus ardu.

Maintenant la plupart des blogs et systèmes de discussions permettent assez facilement de gérer les messages internes, pour peu qu'on s'en donne la peine.

Évidemment plus le système a de l'ampleur et de "l'exposure", plus il faut y mettre les ressources. Les "vrais" hackers ont adoptés les mêmes techniques que les terroristes de la fin du siècle dernier, - évidemment avec des résultats beaucoup moins catastrophique humainement parlant, mais presque autant médiatiquement et avec parfois des dommages économiques assez importants qui nous sont cachés mais qu'on paye chaque mois en frais bancaire et sur nos cartes de crédits.

2006 et les réseaux sociaux virtuels et les hackers 2.0

Revenons à nous moutons et SL (Second Live "pour les nuls"). J'ai des copains qui nous parle assez souvent de Second Life comme vous voyez.

Mon pote Michel y est allé d'un billet sur la frilosité des entreprises québécoises à aller sur Second Life et la découverte de Telus dans cet univers.

Mitch Joel replique plus tard en découvrant l'instigateur de la présence de Telus, qui de son propre chef, a mis un stand et une application de son produit sur SL.

Michel pousse plus a fond quelques jours plus tard, et découvre finalement que personnes aux relations publiques ne connait cette initiative et sont assez perplexe !

La finale :

Encore une mauvaise gestion des communications sur la Toile

La boutique de Telus a été placardé de plywood dans Second Life. Ensuite deux meutres virtuel devant la boutique !

C'est tout beau, tout neuf, mais l'on y répete les mêmes erreurs quand 95-2000. On y mettait des tonnes d'argent en publicité dans de gros portails pour mousser sa marque car leurs propres sites n'avaient aucun rayonnement et étaient "platement conçu", et les communautés naissantes de ces portails étaient souvent frileuses sur le plan du marketing aggressif sur une toile "gratuite". De plus, il ne veillent même pas assez sur ses nouveaux investissements même si c'est dans un univers virtuel.

Pauvre Serge, tu vas avoir du pain sur la planche virtuelle avec ton nouveau poste !

Technorati Tags: veille, second+live, telus, pr, communication, hacker+2.0, relation+publique

29 août 2006

Divertissement 2.0

Les tendances changes assez rapidement selon Google Trends et même ailleurs. Le vidéo musical semble prendre le pas sur le téléchargement de musique dans les nouvelles tendances. De plus, j'ai donné une chance au Mp3 dans ma requête sur Google Trends en utilisant la syntaxe "mp3" OU "music" + "download" contre simplement "music video". Le vidéo musical commence ainsi a reprendre la côte sur le MP3 à partir 2006 !

28 août 2006

Premiere attaque directe de Google sur Microsoft

Google regroupe quelques-un de ses services en ligne (Gmail, Talk, Calendar et Page Creator) pour les entreprises.

La seule nouveauté ici, est que vous pourrez avoir votre logo d'entreprise d'intégré dans ces applications en ligne puisque GMail permettait déjà d'avoir votre propre nom de domaine.

Ce service est en phase beta, comme à l'habitude, mais il y a fort a parier que beaucoup d'autres services s'intégreront bientôt à cette offre comme les; Spreadsheet, Writely (traitement de texte), Desktop Search (qui pourrait possiblement être un service de recherche intranet), Maps (qui pourrait entre autres servir de localisateur de succursales), Web Album et Blogger (pour les communications internes et externes), etc.

Je ne crois pas que Google fasse vraiment mal à Microsoft avec ce regroupement de services, mais les Zoho, Thinkfree et Zimbra vont surement en pâtir un peu !

Technorati Tags: google+apps, google+services

La seule nouveauté ici, est que vous pourrez avoir votre logo d'entreprise d'intégré dans ces applications en ligne puisque GMail permettait déjà d'avoir votre propre nom de domaine.

Ce service est en phase beta, comme à l'habitude, mais il y a fort a parier que beaucoup d'autres services s'intégreront bientôt à cette offre comme les; Spreadsheet, Writely (traitement de texte), Desktop Search (qui pourrait possiblement être un service de recherche intranet), Maps (qui pourrait entre autres servir de localisateur de succursales), Web Album et Blogger (pour les communications internes et externes), etc.

Je ne crois pas que Google fasse vraiment mal à Microsoft avec ce regroupement de services, mais les Zoho, Thinkfree et Zimbra vont surement en pâtir un peu !

Technorati Tags: google+apps, google+services

25 août 2006

Les recherches sur le Web : Un indicateur économique assez précis

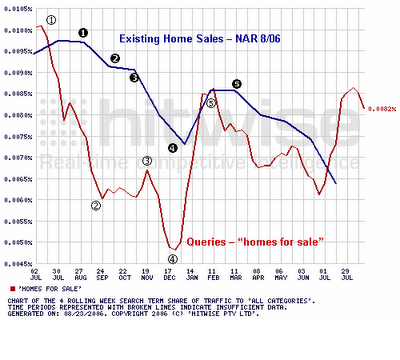

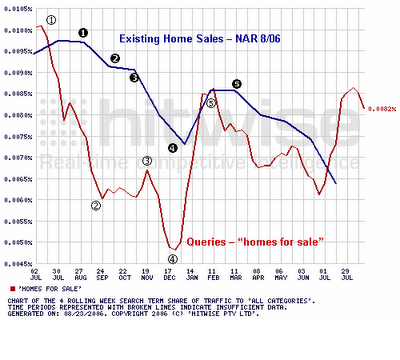

Assez saisissant comme les recherches effectués sur la Toile peuvent être un formidable indicateur économique sur les futures tendances d'un marché.

Ce graphique représente les ventes de maisons compilé par l'association nationale des courtiers américains. Assez frappant comment le volume de recherches effectué sur "homes for sale" se reflète dans les ventes effectives ! Ici on peut probablement assumé que les ventes du mois d'août vont problablement être à la hausse.

Ce graphique représente les ventes de maisons compilé par l'association nationale des courtiers américains. Assez frappant comment le volume de recherches effectué sur "homes for sale" se reflète dans les ventes effectives ! Ici on peut probablement assumé que les ventes du mois d'août vont problablement être à la hausse.

Source : Le blog de Hitwise

Technorati Tags: recherches, optimisation, indicateur+économique, marketing

Ce graphique représente les ventes de maisons compilé par l'association nationale des courtiers américains. Assez frappant comment le volume de recherches effectué sur "homes for sale" se reflète dans les ventes effectives ! Ici on peut probablement assumé que les ventes du mois d'août vont problablement être à la hausse.

Ce graphique représente les ventes de maisons compilé par l'association nationale des courtiers américains. Assez frappant comment le volume de recherches effectué sur "homes for sale" se reflète dans les ventes effectives ! Ici on peut probablement assumé que les ventes du mois d'août vont problablement être à la hausse.Source : Le blog de Hitwise

Technorati Tags: recherches, optimisation, indicateur+économique, marketing

23 août 2006

Regles d'optimisation pour les medias

Un assez bon résumé des principales règles d'optimisation pour un meilleur rayonnement Web vient d'être traduit par Jean-Marie Le Ray et plusieurs autres spécialistes du marketing Web : Voici la liste que je reclasse selon mes expériences et que je bonifie de 3 points essentiels et que je commente aussi :

Original story

- Sachez cibler votre audience (et la géolocalisation aussi pour vos services)

- Utilisez un vocabulaire simple et axé sur les mots-clés utilisés en recherche

- Pensez prioriterement à la pérennité de votre information (un bon archivage est primordial)

- Travaillez votre capital Liens (Rendez votre site un incontournable)

- Récompensez les liens entrants

- Favorisez la diffusion de votre contenu (Essentiel)

- Encouragez les applications composites (Tout en effectuant une veille serrée)

- Soyez une ressource pour les internautes, sans rechercher aucun retour immédiat

- Récompensez les internautes serviables et de qualité (Les produits promotionnels sont là pour cela)

- Participez

- Soyez créateur de contenu

- Soyez vous-même

- N'oubliez pas vos racines, restez humble

- N'ayez pas peur d'expérimenter des choses nouvelles, gardez votre fraîcheur

- Développez une stratégie d'optimisation pour les médias sociaux

- Rendez convivial l’ajout de tags ou de signets

- Choisissez soigneusement vos tactiques d'optimisation

- Intégrez à votre processus de création et vos meilleures pratiques l'optimisation pour les médias sociaux

Original story

22 août 2006

21 août 2006

Google Checkout : Lent démarrage

Après environ 2 mois depuis la sortie de Checkout, Google n'a pas encore 200 marchants dans sa liste de clients. Pire, il vient d'en perdre un assez gros, Levi's qui a retiré Checkout de ses méthodes de paiement en ligne !

Google semble encore une fois avoir lancé trop tôt un service mal ficelé. Plusieurs se plaignent depuis le début, du rôle un peu trop envahissant de Google dans la transaction et du manque d'ouverture de Google sur les données du client pour le suivit après vente du marchant et de quelques délais de traitement de commande très long.

Une nouvelle version de Checkout serait attendu d'ici quelques semaines ce qui pourrait remettre le service en valeur.

Google semble encore une fois avoir lancé trop tôt un service mal ficelé. Plusieurs se plaignent depuis le début, du rôle un peu trop envahissant de Google dans la transaction et du manque d'ouverture de Google sur les données du client pour le suivit après vente du marchant et de quelques délais de traitement de commande très long.

Une nouvelle version de Checkout serait attendu d'ici quelques semaines ce qui pourrait remettre le service en valeur.

S'abonner à :

Messages (Atom)